自动驾驶技术感知路线之争一直是行业关注的焦点。

虽然特斯拉纯视觉方案在业内独领风骚,但多传感融合方案被业内视为实现自动驾驶安全冗余的关键手段。

自动驾驶技术路线之争的背后,除了对感知硬件能力的苛刻要求之外,其实考验的是算法——如何让感知硬件发挥效能最大化。

纯视觉玩家为了保障感知数据维度高,降低数据的丢失,采用「一遍过」的前融合算法。

多传感器融合玩家将安全维度置于首位,在每个传感器独立地输出感知数据信息、处理之后,再汇总处理得出结论,也就是后融合算法。

两种算法的背后各存利弊,前者对于硬件算力要求更高,后者难以发挥单一传感器的最大作用。

随着自动驾驶逐步更加贴近日常驾驶场景,对外部环境探测感知的要求只会越来越高。

01、什么是前融合与后融合算法?

自动驾驶,是一项集感知、决策和控制反馈于一体的技术。

环境感知作为自动驾驶的第一环,是车辆和环境交互的纽带。

自动驾驶系统整体表现的好坏,很大程度上都取决于感知系统的好坏。

如今,基于多传感器融合感知已经成为业内的主流方案,多层数据多来源让最终的感知结果变得更加稳定可靠,更能利用到每个传感器的优势:

- 摄像头虽然能感知丰富的纹理以及颜色信息,但与障碍物之间的距离的感知能力较弱,同时容易受到光照条件影响;

- 毫米波雷达可以全天候工作,提供精确的距离和速度信息,探测距离也比较远,但分辨率较低,无法提供物体高度信息。

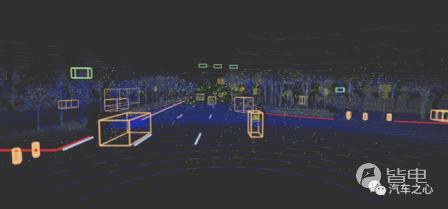

- 激光雷达虽可以较为准确地感知距离信息,但由于采集的点云稀疏,无法获得丰富的纹理和颜色等信息。

而多传感器的融合能够扬长避短,提高整车安全系数,比如毫米波雷达和摄像头的融合思路可以迅速排除大量无效的目标区域,极大地提高识别速度。

摄像头和激光雷达两者的融合,通过利用视觉图像信息进行目标检测,进而获取障碍物的位置,同时还可以识别出障碍物类别信息。

自动驾驶因其问题复杂度高、安全第一等特性,需要依靠多种传感器数据的相互融合来提高感知效果。

而将多传感器信息融合在一起又有多种方式:比如前融合与后融合。

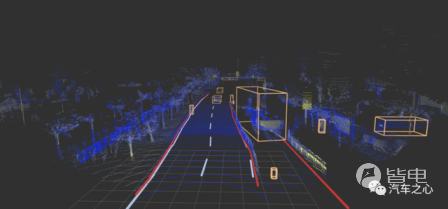

前融合,所有传感器都运行同一套算法,将来自激光雷达、摄像头和毫米波雷达的不同原始数据统一处理,相当于一双超级眼睛通过一套超级算法输出一个结果。

前融合的代表玩家是特斯拉。

特斯拉将毫米波雷达、摄像头等传感装置的不同原始数据统一处理,整合成一套环绕全车 360°的超级传感器,再通过 AI 算法来完成整个感知过程。

在特斯拉的这套方案当中,所有的传感器装置只负责提供原始数据,而算法则负责对原始数据进行整合。

马斯克认为,当毫米波雷达和视觉不一致时,视觉有更好的精度,所以纯视觉比现有的传感器融合方式更好。

这种做法优点就在于不会被单一的传感器信号所影响,所以特斯拉直接移除了毫米波雷达,但这意味着系统对数据的时效性、硬件算力有着极高的要求,需要更高的安全冗余。

这是因为,如果算法出现误判,最终控制层同样会做出错误的指令。

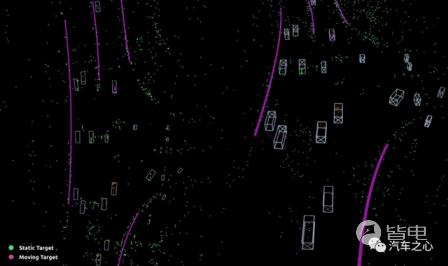

后融合,则通过不同传感器各司其职——超声波雷达、摄像头、毫米波雷达分别通过不同的算法进行独立的感知。

当所有传感器完成目标数据(如目标检测、目标速度预测)生成后,将这些信息和目标列表经过校验和比对:

在这个过程中,传感器会通过算法过滤低置信度或者无效的原始数据,最后进行识别物体的合并,完成整个感知过程。

这也是目前业内主流的融合方案。

比如华为 ADS 智能驾驶方案,通过毫米波雷达、摄像头等传感器进行不同算法的独立感知,再分别生成独立的信息。

举个例子,激光雷达看到的是一条柯基,毫米波雷达看到的是一条狗,而摄像头看到的是一只小动物,再将这些信息汇总处理,系统做出综合判断。

当然,后融合感知框架也存在先天的不足:

单一传感器会有能力限制,在特定条件下可能发生误检和漏检,比如摄像头不擅长判断距离和位置,雷达不擅长判断颜色和纹理,系统需要对它们的信息进行互相验证,才能达到更高的可信度。

元戎启行 CEO 周光曾举例指出前、后融合的感知能力:

「假设在你手上有个手机,激光雷达只能看到手机一个角,摄像头只能看到第二个角,毫米波雷达可以看到第三个角。

如果用后融合算法,由于每个传感器只能看到一部分,因此物体非常有可能不被识别,最终被滤掉。

但在前融合中,由于它集合了所有数据,相当于可以看到这个手机的三个角,那对于前融合来说,是非常容易识别出这是一台手机的。」

这种差异化现象自然也产生不同的结果,比如面对相同的复杂场景,后融合出现极端场景的概率为 1%,前融合则能够将这个概率降低至 0.01%。

两种技术路线各有优劣,前融合胜于高精度,后融合胜于高效率,背后不同流派的玩家自然各持硬件论、算力论之争。

02、全融合算法解决了什么问题?

前段时间,知乎有一个关于「自动驾驶的关键,是硬件还是软件」的帖子引起了热议。

大家争议的焦点在于硬件上车之后,车企能否将其作用发挥最大化。

在话题的讨论中,飞凡汽车智驾团队首席科学家金杰盂回应:

智能驾驶硬件决定了软件的天花板,软件决定了用户体验,只不过相对于硬件性能的突破性提升,软件算法到了必须变革的时刻。

确实,如果自动驾驶能够一直依靠堆砌硬件的方式解决问题,看起来是一个一劳永逸的方案。

但实际情况是,如果算法能力不能有效跟上,硬件只能沦为摆设。

那么,飞凡汽车如何在智能化时代转换思考方式,做到「硬件堆砌」不再是一时的商业噱头,而是能够让硬件发挥更高的效率,从而达到同一个硬件在不同场景中发挥不同作用的目标呢?

金杰盂认为,通过软件的控制,硬件可以在不同场景下呈现出不同的状态,解决不同的问题,相当于硬件随时需要成为软件可以调用的资源。

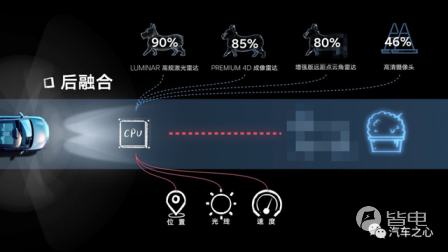

比如在硬件数量层面:飞凡 R7 共搭载了 33 个感知硬件,包括国内首发量产的 Premium 4D 成像雷达、增强版远距离点云角雷达 、厘米级高精定位系统。

而在硬件质量层面:来自 Luminar 的激光雷达,可以实现超 500 米的最远探测距离以及水平 120°与垂直 26°的探测视角。

两颗来自德国采埃孚的第五代 Premium 最高性能毫米波雷达,实现最远探测距离 350 米,高于常规雷达的 210 米,即便是面对恶劣的极端天气、光照条件,也可以正常运作。

Premium 4D 成像雷达能够同时对距离、速度、水平方位角、垂直高度四个纬度的识别,包括路沿、道路分岔口等自由空间,以及施工围栏、雪糕筒等静止障碍物。

全车 12 个 800 万像素摄像头覆盖车辆 360°的全范围感知,对动态人车交通参与者、地面标识、红绿灯、限速标识等交通环境的感知信号更加精准。

最后是软件算法能力。

飞凡 R7 搭载英伟达 Orin 芯片,单颗算力 254Tops,最高可扩展到 500-1000+Tops,相较于上一代 Xavier 芯片,运算性能提升了 7 倍,能够快速将路况信息转化为实际图像,并快速处理路面突发情况。

这种做法看起来就是在堆砌硬件?但这背后实际的情况是怎么样的?

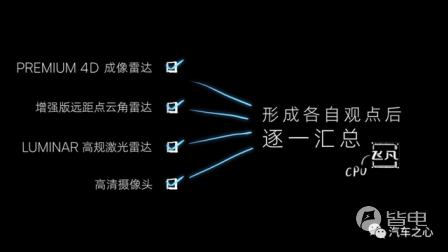

金杰盂在知乎的回答中提到一个叫做「全融合」的概念。

「全融合」的工作流程是这样的:

首先,将前融合的多任务、多特征网络、深度神经网络输出的感知结果,与后融合独立输出的感知结果进行综合比对,实现混合融合;

其次,依靠高带宽、超算力芯片平台的安全冗余部署,通过三重融合(毫秒级内)完成感知、融合、预测、决策、执行等一整套动作。

简单理解,就是先用前融合的思路得出解法,再用后融合的思路得出另一种解法,最后系统再将两种解法进行融合比对、检查,得出一个感知、效率双赢的结果。

那么,飞凡汽车眼中具备软件变革意义的「全融合算法」,表现如何?

从目前官方公布的视频来看,飞凡汽车的 RISING PILOT 系统主要表现在匝道全域增强识别、超灵敏静态路障感知、雨雪雾天超视距识别等极端场景。

比如针对目前无法提前识别进入多岔口匝道的三角区域,或者是在匝道口数量多、复杂的情况下,系统识别失败直接错过匝道、自动退出等情况。

RISING PILOT 可以通过更远距离的综合感知,提前识别匝道三角区域,进而拥有更充裕的时间,在安全的方位内提前进行变道、汇入匝道。

比如遇到施工区域类场景,出现因无法准确识别静态路障,或者是根本无法识别施工区域而出现碰撞事故的情况:

- RISING PILOT 能够精准识别静态障碍物的三维几何位置、尺寸和类型,并快速做出提前避让的反应。

- 即便只有雪糕筒或施工提示牌也可提前精准识别,并通过预测和决策模型,快速反应实现提前避让。

可以预见的是,当智能驾驶经历了在车载传感器种类、数量上的花式堆砌,以及在智能驾驶硬件上的算力内卷,想要自家的智驶技术能够脱颖而出,最终大概率还是要回到软件算法上。

03、硬件,需要随时成为软件算法的调度资源

如果说自动驾驶发展是一个需要长期锤炼的过程,那么「技术迭代」则是这个过程的试金石。

摄像头从单目升级到多目,像素从 200 万到 800 万,毫米波雷达从低频的 24GH 向 77GHz、79GHz 升级,激光雷达翻越车规级量产和降成本两座大山,从机械旋转式向 MEMS 演进。

在自动驾驶硬件逐步迈向成熟之后,算法自然成为自动驾驶系统好坏评判的重要依据。

前融合的优势毋庸置疑,但极少有车企能够真正把前融合算法做好,几乎 99% 车企都处于 Demo 阶段。

这也就是为什么大多数车企选择后融合的原因。

在技术尚未真正成熟的背景下,现阶段的前融合、后融合在极端场景中逐步暴露出各自的不足,这些问题仅依靠自身软件算法的升级迭代和硬件的加强,也很难达到 100% 的理想效果。

虽然全融合目前被视为能够取长补短、避其所短的算法,但对于软硬件的基础能力、两者与整车之间如何达成默契配合仍是难点。

除此之外,不同细分领域的入局者同样存在不同的观点,比如坚持前融合才是符合第一性原理的周光就表示:

「算法方面的欠缺,无法靠堆硬件来弥补,要想保障 L4 级 Robotaxi 的安全性,绝不能采用后融合的形式,多传感器前融合是必要路线。」

何小鹏的观点是强视觉感知,激光雷达只是辅助作用,并且强调算法和数据的重要性。

「体验、成本、安全、综合使用范围」是何小鹏对于智能驾驶技术优劣的评判,并且四个维度都需要保持一定平衡。

如果硬件堆砌只能带来硬件水平上的高度,那么软件才是对战时最有力的武器。

摩根士丹利曾在报告中提到,传统的汽车硬件占据了整车价值的 90%,软件仅占据 10%,但未来软件所占的价值比重将会提高到 40%,硬件则将下降到 40%。

德勤咨询更是进一步指出,决定未来汽车差异性的将是软件及软件更新迭代所带来的性能和功能变化。

这也为什么如今全栈自研成为车企追逐的路线,在硬件普遍堆料的背景下,自动驾驶软件算法已经成为车企打造差异化智能驾驶能力的关键。

软件算法的能力,在硬件水平足够的前提下,直接决定了自动驾驶性能的实际表现。

高阶智能驾驶的拐点,或许从软件开始

高阶智能驾驶的拐点,或许从软件开始

1

1 收藏

收藏 加电

加电